Latar Belakang

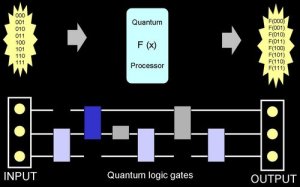

MapReduce

adalah model pemrograman rilisan Google yang ditujukan untuk memproses data

berukuran raksasa secara terdistribusi dan paralel dalam cluster yang terdiri

atas ribuan komputer. Dalam memproses data, secara garis besar MapReduce dapat

dibagi dalam dua proses yaitu proses Map dan proses Reduce. Kedua jenis proses

ini didistribusikan atau dibagi-bagikan ke setiap komputer dalam suatu cluster

(kelompok komputer yang salih terhubung) dan berjalan secara paralel tanpa

saling bergantung satu dengan yang lainnya. Proses Map bertugas untuk

mengumpulkan informasi dari potongan-potongan data yang terdistribusi dalam

tiap komputer dalam cluster. Hasilnya diserahkan kepada proses Reduce untuk

diproses lebih lanjut. Hasil proses Reduce merupakan hasil akhir yang dikirim

ke pengguna. Untuk menggunakan MapReduce, seorang programer cukup membuat dua

program yaitu program yang memuat kalkulasi atau prosedur yang akan dilakukan

oleh proses Map dan Reduce. Jadi tidak perlu pusing memikirkan bagaimana

memotong-motong data untuk dibagi-bagikan kepada tiap komputer, dan

memprosesnya secara paralel kemudian mengumpulkannya kembali. Semua proses ini

akan dikerjakan secara otomatis oleh MapReduce yang dijalankan diatas Google

File System.

Tujuan

MapReduce

adalah model pemrograman rilisan Google yang ditujukan untuk memproses data

berukuran raksasa secara terdistribusi dan paralel dalam cluster yang terdiri

atas ribuan komputer. Dalam memproses data, secara garis besar MapReduce dapat

dibagi dalam dua proses yaitu proses Map dan proses Reduce

PEMBAHASAN

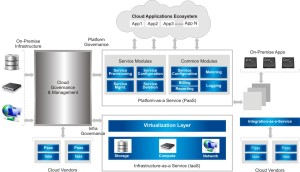

Perkembangan

teknologi di era ini menggunakan konsep - konsep seperti social networking,

open, share, colaborations, mobile, easy maintenance, one click, terdistribusi,

scalability, concurency, dan transparan. Sampai saat ini trend teknologi Cloud

Computing (Komputasi Awan) masih terus diteliti dalam penelitian - penelitian

para pakar IT dunia. Dengan berbagai kelebihan dan kekurangan, Cloud Computing

hadir dengan memudahkan akses data dari

mana saja dan kapan saja, karena dengan memanfaatkan internet dan menggunakan

perangkat fixed atau mobile device menggunakan internet cloud sebagai tempat

penyimpanan data, aplikasi dan lainya. Teknologi ini akan memberikan banyak

keuntungan baik dari sisi pemberi layanan (provider) atau dari sisi user.

Penerapan teknologi ini memberikan dampak yang sangat signifikan bagi

pengembangan teknologi itu sendiri, baik dari sisi pengguna maupun dari sisi

industri. Pengguna diuntungkan dengan semakin mudahnya memperoleh atau

mengunduh data secara cepat dan mudah karena banyak layanan yang dibuka oleh

pihak industri. Keuntungan bagi pihak industri pun tidak kalah besar dengan

kemudahan yang didapat oleh pengguna, karena dengan semakin majunya teknologi

cloud computing akan semakin memudahkan industri untuk memasarkan produk dan

menyebarkan informasi secara meluas keseluruh penjuru dunia. Cloud computing

adalah gabungan pemanfaatan teknologi komputer dan pengembangan berbasis

internet. Cloud komputasi atau komputasi awan adalah pengembangan teknologi

komputer dengan pengembangan internet, dimana pengembangan IT sangat dimanjakan

oleh adanya sistem yang berbasis internet disini.

Komputasi grid

Komputasi

grid adalah sumber daya yang dibutuhkan banyaknya komputer yang terdistribusi

dan terpisah secara geografis, jadi komputasi grid ini untuk memecahkan masalah

bersekala besar, yang dimaksud besar adalah suatu medan yang sangat jauh atau

terpisahnya secara geografis yang terhubung atau terdistribusi dihubungkan

dengan adanya komputasi cloud.

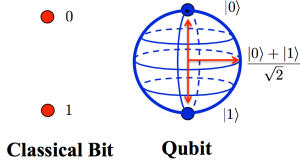

Virtualisasi

Virtualisasi

dibidang komputer adalah sebuah teknologi, yang memungkinkan untuk membuat

versi virtual yang bersifat fisik, contohnya sistem operasi, storge data atau

sumber daya jaringan. Disini memiliki Hypervisor yang gunanya untuk memproses

sebuah software atau firmware.

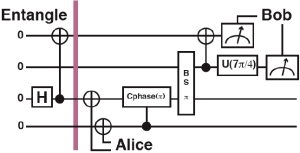

Distributed Computation dalam Cloud

Computing

Mempelajari

tentang pengunaan terkoordinasi dari komputer secara fisik terpisah atau

terdistribusi, untuk dalam komputasi cloud dimana media dapat berjalan

bersamaan pada banyaknya komputer yang terhubung melalui media internet.

Map Reduce danNoSQL (Not Only SQL)

Map

Reduce danNoSQL (Not Only SQL) adalah sebuah pemogramaan framework guna untuk

membantu user mengembangankan sebuah data yang ukuran besar dapat terdistribusi

satu sama lain. Map-Reduce adalah salah satu konsep teknis yang sangat penting

di dalam teknologi cloud terutama karena dapat diterapkannya dalam

lingkungan distributed computing. Dengan demikian akan menjamin skalabilitas

aplikasi kita.

Salah

satu contoh penerapan nyata map-reduce ini dalam suatu produk adalah yang

dilakukan Google. Dengan inspirasi dari functional programming map

dan reduce Google bisa menghasilkan filesystem distributed yang sangat scalable, Google

Big Table. Dan juga terinspirasi dari Google, pada ranah open source

terlihat percepatan pengembangan framework lainnya yang juga bersifat

terdistribusi dan menggunakan konsep yang sama, project open source tersebut

bernama Apache Hadoop.

NoSQL

adalah istilah untuk menyatakan berbagai hal yang didalamnya termasuk database

sederhana yang berisikan key dan value seperti Memcache, ataupun

yang lebih canggih yaitu non-database relational seperti MongoDB, Cassandra, CouchDB,

dan yang lainnya.

Wikipedia

menyatakan NoSQL adalah sistem menejemen database yang berbeda

dari sistem menejemen database relasional yang klasik dalam beberapa hal. NoSQL

mungkin tidak membutuhkan skema table dan umumnya menghindari operasi join dan

berkembang secara horisontal. Akademisi menyebut database seperti ini

sebagai structured storage, istilah yang didalamnya mencakup sistem

menejemen database relasional.

NoSQL

Nosql

adalah sebuah memcache dari bagian database sederhana yang berisi key dan

value. Database ini bersifat struktur storage dimana sistem databasenya yang

berbeda dengan sistem database relasional. Nosql tidak membutuhkan skema table

dan menghindari operasi join dan berkembang secara horizontal. Selain itu NoSQL

merupakan suatu bahasan yang jauh dari arti kata yang dibaca. Tidak berarti

tanpa sql query. Melainkan bagaimana suatu sql query digunakan seminimal

mungkin dalam suatu program database. Dengan memanfaatkan teknologi NoSQL ini,

diharapkan mampu mengurangi beban server. Selain itu, hal ini juga memudahkan

programmer dalam membuat suatu program dan proses pengembangannya. Penjelasan

lebih mengenai NoSQL database akan dijelaskan pada sub bab dibawah ini.

Database NoSQL, juga

disebut Not Only SQL, adalah sebuah pendekatan untuk pengelolaan

datadan desain database yang berguna untuk set yang sangat

besar data terdistribusi. NoSQL, yang mencakup berbagai teknologi dan

arsitektur, berusaha untuk memecahkan masalah skala bilitas dan kinerja data

yang besar yang database relasional tidak dirancang untuk

menangani.NoSQL ini sangat berguna ketika perusahaan perlu untuk

mengakses dan menganalisis sejumlah besar data terstruktur atau data yang

disimpan dari jarak jauh pada beberapa virtual server di

awan.

Berlawanan

dengan kesalahpahaman yang disebabkan oleh namanya, NoSQL tidak melarangbahasa

query terstruktur (SQL) Meskipun benar bahwa beberapa sistem NoSQL sepenuhnya non-relasional,

yang lain hanya menghindari fungsi relasional dipilih seperti skema tabel tetap

dan bergabung dengan operasi. Sebagai contoh, daripada menggunakan tabel, database

NoSQL mungkin mengatur data menjadi objek, kunci / nilai berpasangan atau tupel

Kesimpulan

Map

Reduce danNoSQL (Not Only SQL) adalah sebuah pemogramaan framework guna untuk

membantu user mengembangankan sebuah data yang ukuran besar dapat terdistribusi

satu sama lain. Map-Reduce adalah salah satu konsep teknis yang sangat penting

di dalam teknologi cloud terutama karena dapat diterapkannya dalam

lingkungan distributed computing. Dengan demikian akan menjamin skalabilitas

aplikasi kita.

Salah

satu contoh penerapan nyata map-reduce ini dalam suatu produk adalah yang

dilakukan Google. Dengan inspirasi dari functional programming map

dan reduce Google bisa menghasilkan filesystem distributed yang sangat scalable, Google

Big Table. Dan juga terinspirasi dari Google, pada ranah open source

terlihat percepatan pengembangan framework lainnya yang juga bersifat

terdistribusi dan menggunakan konsep yang sama, project open source tersebut

bernama Apache Hadoop.

Daftar Pustaka

http://no21reason.blogspot.com/2013_04_01_archive.html

Sumber : http://putrifebiani.blogspot.co.id/2014/05/map-reduce-dan-nosql.html